DIE SINGULARITÄT IST NAH!

Die AIs werden immer schneller immer besser

Auf meinem Mastodon-Profil auf hachyderm.io nenne ich 2029 als das Jahr, zu dem ich die Singularität erwarte. Die Singularität, das ist der Moment, zu dem die AI intelligenter wird als wir Menschen, um sich dann in Kürze in rasantem exponentiellen Wachstum weiter zu entwickeln, bis zu einem für uns undenkbaren Level.

Hintergrund dieses Gedankens ist, dass, sobald die AI besser darin ist, AIs zu programmieren als wir, nicht mehr ein paar tausend clevere Menschen-Softwareentwickler, sondern Millionen cleverere Maschinen-Entwickler verfügbar sein werden, die mit jeder Generation von so entwickelter AI nochmal cleverer sein werden.

Wenn man sich die Zeit zwischen Opus 4.5 und Claude Opus 4.6 betrachtet und die Entwicklung von GPT-5.2 hin zu GPT-5.3 Codex, zusammen mit den deutlich gestiegenen Fähigkeiten in Bereichen wie Softwareentwicklung, könnte man meinen, dass es keine weiteren drei Jahre mehr dauert, sondern vielleicht... nur noch eines...?

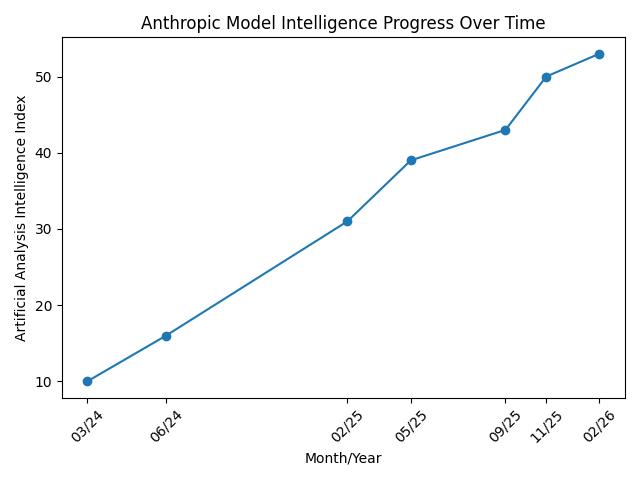

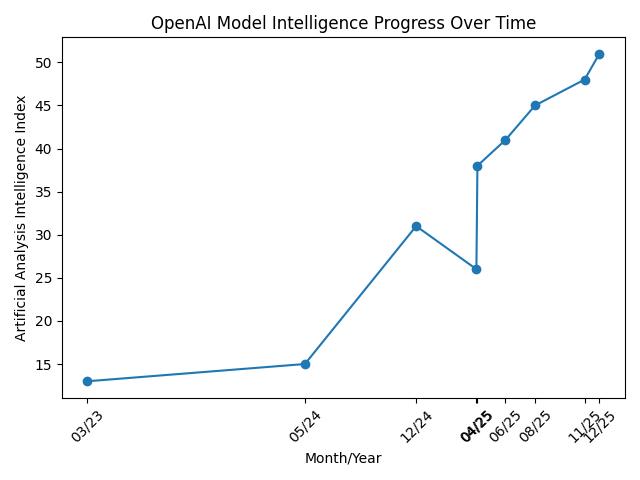

Sieht man sich an, wie sich die Score der einzelnen Modelle beim "Artificial Analysis Intelligence Index" über die Zeit entwickelt, sieht man auch ein kontinuierliches - wenn auch nicht exponentielles sondern eher lineares Wachstum:

Anthropics Modelle im Lauf der Zeit

OpenAI Modelle im Lauf der Zeit

Der komische Ausrutscher bei OpenAI ist GPT-4.1, das im April 2025 erschien und mit schlechten 26 Punkten aufwartet.

Und selbst wenn man die natürlich übertriebenen Kommentare der Hersteller zur Beteiligung der AIs liest:

OpenAI:

"GPT 5.3 Codex ist unser erstes Modell, das maßgeblich an seiner eigenen Entwicklung beteiligt war. Das Codex-Team nutzte frühe Versionen, um sein eigenes Training zu debuggen, seine eigene Bereitstellung zu verwalten und Testergebnisse sowie Evaluierungen zu diagnostizieren – unser Team war überwältigt davon, wie sehr Codex seine eigene Entwicklung beschleunigen konnte."

Anthropic:

"We build Claude with Claude. Our engineers write code with Claude Code every day, and every new model first gets tested on our own work. With Opus 4.6, we’ve found that the model brings more focus to the most challenging parts of a task without being told to, moves quickly through the more straightforward parts, handles ambiguous problems with better judgment, and stays productive over longer sessions."

dann kann man, auch mit dem sprichwörtlichen Körnchen Salz, zum Schluss kommen: die AIs unterstützen die AI-Entwickler beim Entwickeln der nächsten AIs in einer Weise, die diesen Prozess schon jetzt beschleunigt. Der Weg zur Singularität hat also bereits begonnen.

Andere Beobachtungen

Auf shumer.dev: Something big is happening schreibt ein anderer Softwareentwickler über seine ganz ähnlichen Beobachtungen. Seine Schlussfolgerung ist - in meinen Worten, dass die Singularität nah ist, sie unser Leben massiv verändern wird, und wir einige Dinge überdenken sollten. Wie wollen wir lernen, was sind neue Möglichkeiten, die wir haben usw.

Auch der immer schon als Technik-Optimist bekannte Marc Andersseen hat kürzlich in einem überraschend interessanten Podcast (ich mag Marc nicht sehr) darüber geredet, dass die nahende Welle hochintelligenter KIs diejenigen, die sich aktiv Beschäftigen, die breites Wissen aufbauen, stark beschleunigen wird, während diejenigen, die einfach so weiter machen, Schwierigkeiten in der Post-AI-Welt haben werden: Podcastfolge auf Spotify

Ich habe absichtlich nach skeptischen Sichten auf AI gesucht. Selbst die zeigen, oft auf unerwartete weise, wie rasant der Fortschritt gerade ist. Beispielsweise schreibt Forbes Ende Dezember 2025 noch, dass der AGI Hype vorbei sei, weil die neusten Modelle wie GPT-5 hinter den Erwartungen zurückgeblieben sind und nun alle zurückrudern. Der Artikel war zum Zeitpunkt der Veröffentlichung bereits veraltet, seine Schlussfolgerungen überholt. Zwei Monate sind seitdem vergangen, und im Vergleich zu GPT 5.3 codex und Opus 4.6 wirkt das im Artikel noch als neustes Modell benannte GPT5 wie ein Modell aus der Steinzeit.

Auch ansonsten stellte es sich heraus, Skeptiker zu finden, deren Artikel fachlich halbwegs fundiert und auf der Höhe der so rasanten Zeit sind.

Und dann gibt es die AI-Hyper.

Wie den psychopatischen reichsten Mann der Welt, der in seinen AI Labs jetzt eine "Macrohard" Abteilung gegründet hat, immer für einen Kalauer gut, um mit AI das Softwarebusiness, wie man so schön anglizistisch sagt, zu disrupten. Wie die Aktienananalysten, die im Januar die Aktien vieler "Software as a Service" Hersteller in den Keller geschickt haben, zum Teil in der Annahme, dass man demnächst nur aufschreibt "schreib mir bitte ein Textverarbeitungsprogramm das besser ist als Word" und wartet und fertig.

Da sind wir doch noch ein gutes Stück von weg.

Meine eigenen Experimente enden mit uneindeutigen Erkenntnissen. Zum einen: Ich habe ChatGPT 5.2 letzte Woche gebeten, ein dreiseitiges Markdown-Dokument in HTML zu verwandeln. Nach sehr gutem Start hat es bei 2/3 des Dokuments einfach aufgehört. Ich fühlte mich an ChatGPT 3.5 Zeiten erinnert.

Zum Anderen: Ich habe aber auch OpenAI Codex + GPT 5.3 codex gebeten, mir eine persönliche Nachrichten-App zu programmieren, die alle möglichen bekannten und für mich relevanten RSS-Feeds scannt, von einem lokalen LLM übersetzen, zusammenfassen und nach meinen Wichtigkeitskriterien priorisieren lässt und mir so auf mich zugeschnittene Nachrichten aush ca. 50 Quellen präsentiert. eine Stunde verging, dann lief die App perfekt. Früher wäre das ein Job für 2 Wochenenden gewesen.

Was ist sicher?

Angesichts der ganzen Für und Wider zum Thema "sind wir nahe an der Singularität" fragt man sich, was man jetzt halbwegs sicher annehmen kann.

Zum einen ist sicher, dass seit Jahren die Fähgikeiten, die Nützlichkeit von LLMs kontinuierlich steigen, und dass die Geschwindigkeit dieser Steigung eher zunimmt.

Zum anderen ist sicher, dass die aktuelle Transformer-Architektur von LLMs prinzipbedingt halluzinieren kann, und dass ein von uns Menschen ungeprüftes Agieren von Agenten ausserhalb einer Sandbox, also Agenten, die echte Dinge in unserem Leben verändern wie etwa Reisen buchen oder Dinge kaufen, eine sehr schlechte Idee ist. Wie bei Sprachmodellen normal, liefert der Ansatz in 95% der Fälle erstaunliche, positive Ergebnisse. Die 5% Desaster sind diese Erfolge aber nicht wert - die eigenen Dateien auf der Festplatte des Computers sind mir genauso lieb wie mein Geld.

Wo stehen wir also wirklich?

Das kann man nicht sicher sagen. Ich glaube aber, nach etlichen Jahren kontinuierlichem rapiden Wachstum der LLMs, und ohne ein mir bekanntes konkretes hartes Hindernis in Sicht ist es vernünftig, den "Default" zu wechseln.

Mir gefällt der Vergleich zu einem Backgammon-Spiel: Backgammon ist ein Würfelspiel mit viel Glück und fast so viel Strategie. Zu jedem Zeitpunkt kann man sagen (speziell wenn man eine AI bemüht, die das Spiel perfekt beherrscht), wer in einem Spiel in Führung liegt, wie wahrscheinlich es ist, dass ich dieses Spiel gewinnen werde. Es gibt aber Momente groben Glücks oder Pechs: man würfelt in aussichtsloser Position zwei Sechserpaschs und gewinnt.

Ähnlich ist es mit den AIs. Es könnte sich bald herausstellen, dass LLMs auf eine harte Grenze weiteren Wachstums stoßen. Man dachte früher, wenn das gesammelte Wissen des Internets als Trainingsmaterial verwendet wurde, wäre dieser Punkt erreicht. Die Annahme stellte sich als falsch heraus. Zum Beispiel fand man Domänen wie Software-Entwicklung, wo man nachprüfen kann, ob das LLM-Ergebnis korrekt arbeitet, weil das Programm funktioniert oder nicht. Diese Ergebniss helfen, das LLM weiter trainieren. Genauso könnte einer der großen Hersteller - ich würde auf Google tippen, weil die AI-mäßig weit breiter aufgestellt sind als Anthropic und OpenAI - auf eine brilliante neue Idee kommen, die die nächste AI sofort auf ein menschengleiches Intelligenzniveau hebt. Wir wissen es nicht. Im Backgammon heisst das "Joker" und "Anti-Joker": Würfelwürfe, die den erwarteten Ausgang sofort ändern.

Doch müsste ich heute den erwarteten Ausgang bei weiterem ruhigen Spielverlauf schätzen, müsste ich wohl meine Prognose der Singularität in 2029 etwas vorverlagern, vermutlich auf 2028. Und dann hätte ich mehr Sorge, dass diese Schätzung zu konservativ ist als zu optimistisch.

Was sind die Konsequenzen?

Die Artikel wie "Something big is happening" sollte man gründlich lesen und darüber reflektieren. Speziell sollte man nicht auf oft veraltete Internet-Meinungen vertrauen ("haha, kann nicht mal die Anzahl von "e"s in "Erdbeere" berechnen haha") oder ("das ist alles nur Slop ohne Nutzen"). Ich nutze LLMs jeden Tag. Mehrfach. Ich habe dabei immer im Kopf, dass es, wie auch, wenn ich Menschen frage, eine kleine Wahrscheinlichkeit gibt, dass die Ergebnisse nicht stimmen. Entsprechend prüfe ich die Ergebnisse mehr oder weniger abhängig von ihrer Wichtigkeit für mich. Doch meistens stimmen sie, und AIs beschleunigen so viele meiner Arbeiten dramatisch, geben mir ganz andere Möglichkeiten. Ich kenne nach ca. 8h Arbeit mit ChatGPT die Unreal Engine ganz gut, konnte selbst ein kleines Spiel mit 3D-Animationen, mit C++ Code, entwickeln. Früher war allein die Idee, sich mit so etwas zu beschäftigen, absurd, wenn man einen Job und eine Familie hat. Anderes Beispiel: Ich habe bestimmt 10 kleine Apps geschrieben, die ich täglich verwende. Also ich habe sie spezifiziert, die AI hat sie ausprogrammiert. Ohne AIs ein viel zu hoher Aufwand.

Mein Tipp (ähnlich wie die vom Autor des "Something big is happening": gib den LLMs echte Aufgaben. Nicht nur "Was ist die Hauptstadt von Ghana". Nicht nur Buchstaben zählen. Etwas, das dich im (Büro)leben Zeit kostet. Vielleicht willst du was mit Excel machen, weißt nicht wie. Vielleicht willst du deine Fotobibliothek verwalten. Einige Dinge werden schief gehen (warum zum Teufel kann selbst Opus 4.6 nicht den "finde alle Ampeln" Captcha bestehen?), andere werden dich umhauen. Und nicht nur bereitet dich das auf eine halbwegs wahrscheinliche Zukunft mit superintelligenten AIs vor, es macht auch Spaß.